概率论中”不相关”与”独立”是描述随机变量关系的两个重要概念,它们既有联系又有区别。理解这两个概念的区别对于深入掌握概率论和统计学至关重要。

数学定义

在概率论中,两个随机变量 X 和 Y 之间的关系可以通过”不相关”(uncorrelated)和”独立”(independent)来描述。

不相关指的是两个随机变量的协方差为零。数学上表示为:

Cov(X, Y) = E[(X – E[X])(Y – E[Y])] = 0

其中 E[X] 和 E[Y] 分别是随机变量 X 和 Y 的期望值。

独立指的是两个随机变量的联合概率分布等于各自边缘概率分布的乘积。数学上表示为:

P(X ≤ x, Y ≤ y) = P(X ≤ x)P(Y ≤ y) 对于所有的 x, y

关系分析

核心关系

-

独立 ⇒ 不相关:如果两个随机变量独立,那么它们一定不相关。这是概率论中的一个重要定理。

-

不相关 ⇏ 独立:如果两个随机变量不相关,它们不一定独立。这是理解这两个概念区别的关键。

数学证明

定理:如果 X 和 Y 独立,则 Cov(X, Y) = 0。

证明:

如果 X 和 Y 独立,则 E[XY] = E[X]E[Y]。

Cov(X, Y) = E[XY] – E[X]E[Y] = E[X]E[Y] – E[X]E[Y] = 0

典型例子

例1:独立且不相关的例子

考虑两个独立的随机变量 X 和 Y,其中 X ~ N(0,1),Y ~ N(0,1)。

由于它们独立,根据上述定理,Cov(X, Y) = 0,所以它们不相关。

例2:不相关但不独立的例子

这是一个经典的反例。设 X ~ N(0,1),Y = X²。

计算协方差:

Cov(X, Y) = E[XY] – E[X]E[Y] = E[X³] – E[X]E[X²]

由于 X ~ N(0,1),E[X] = 0,E[X³] = 0(正态分布的三阶矩为0),所以:

Cov(X, Y) = 0 – 0 × 1 = 0

因此 X 和 Y 不相关。

但是 Y = X²,显然 X 和 Y 不是独立的,因为知道 X 的值就完全确定了 Y 的值。

例3:二维正态分布的特殊情况

对于二维正态分布 (X, Y) ~ N(μ₁, μ₂, σ₁², σ₂², ρ),其中 ρ 是相关系数。

在这种情况下:

– 如果 ρ = 0,则 X 和 Y 不相关

– 对于二维正态分布,不相关等价于独立

这是二维正态分布的一个特殊性质。

直观解释

不相关的含义

不相关只描述了两个随机变量之间的线性关系。协方差为零意味着没有线性相关性,但可能存在非线性关系。

独立的含义

独立意味着两个随机变量之间没有任何关系,包括线性关系和非线性关系。知道一个变量的值不会对另一个变量的分布产生任何影响。

应用场景

金融领域

在投资组合理论中:

– 不相关的资产可以帮助分散风险

– 独立的资产提供更好的分散化效果

机器学习

在特征选择中:

– 不相关的特征可能仍然包含有用信息

– 独立的特征通常更有利于模型训练

统计推断

在假设检验中:

– 独立性假设通常比不相关假设更强

– 违反独立性假设可能导致严重的统计推断错误

判断方法

数学方法

- 协方差检验:计算 Cov(X, Y),如果为零则为不相关

- 独立性检验:检查 P(X ∈ A, Y ∈ B) = P(X ∈ A)P(Y ∈ B) 是否对所有集合 A, B 成立

实际应用中的判断

在实际应用中,独立性检验通常很困难,因此:

1. 如果能够从问题的物理或数学背景确定独立性,则直接使用

2. 如果无法确定独立性,但能证明不相关,则需要谨慎处理

3. 对于正态分布等特定分布,可以利用不相关等价于独立的性质

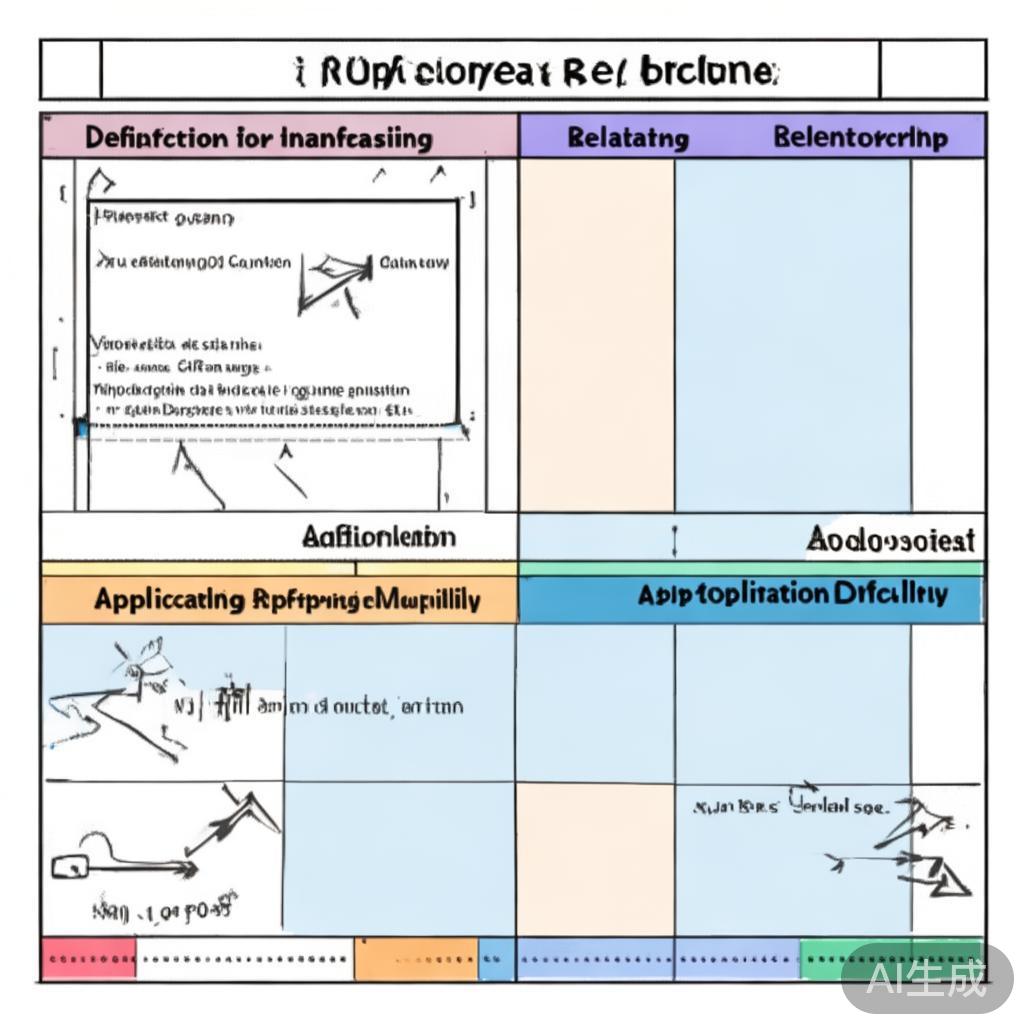

总结

| 特性 | 不相关 | 独立 |

|---|---|---|

| 定义 | Cov(X,Y) = 0 | P(X,Y) = P(X)P(Y) |

| 关系 | 独立一定不相关 | 不相关不一定独立 |

| 意义 | 无线性关系 | 无任何关系 |

| 检验难度 | 相对简单 | 通常很困难 |

| 应用范围 | 线性关系分析 | 一般概率分析 |

理解”不相关”与”独立”的区别是掌握概率论和统计学的关键一步。在实际应用中,需要根据具体问题选择合适的概念和方法,避免混淆这两个重要的统计概念。

关键字:概率论, 不相关, 独立, 随机变量, 协方差, 相关系数, 统计学, 数学定义, 实际应用